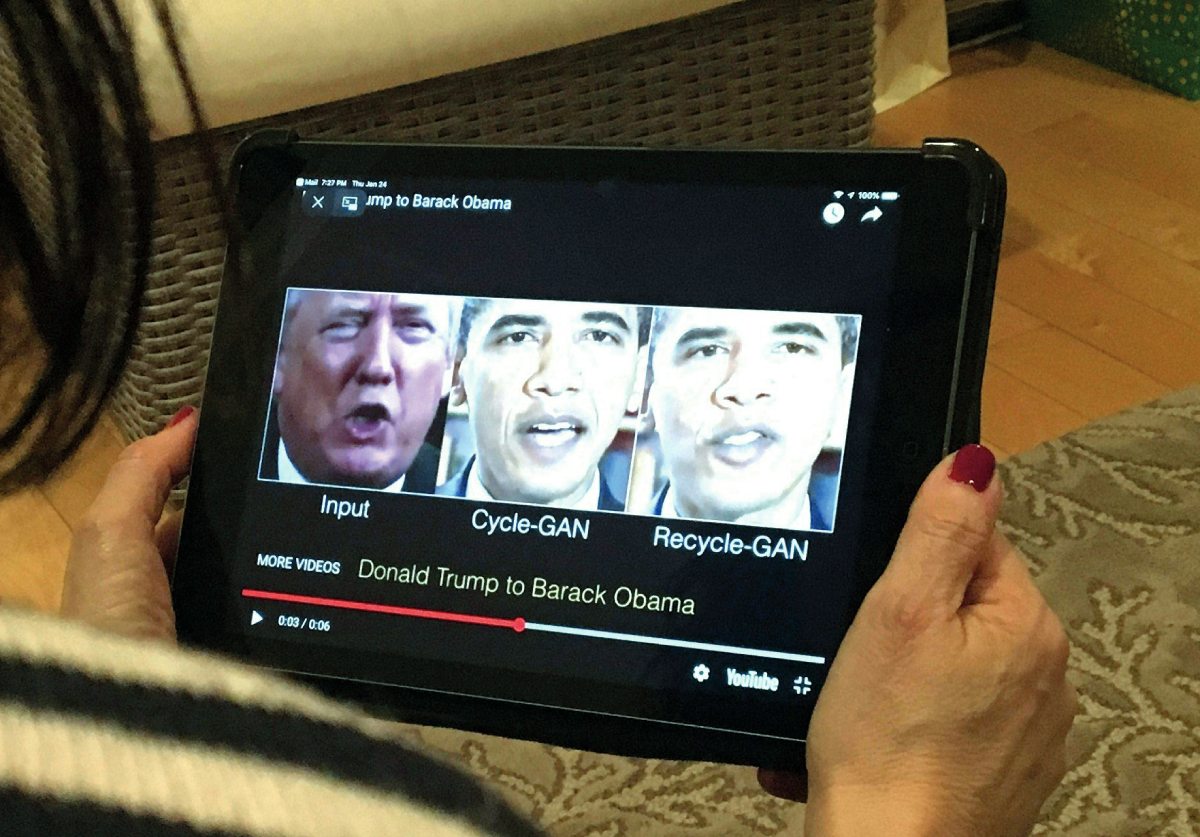

Tres tipos de ‘deepfakes’

▶️ Cambio de cara: ‘Face-swap’

Intercambio facial que sustituye el rostro original por otro, sea de un personaje real o ficticio, que se puede realizar en imagen fija, vídeo o retransmisión en directo, como permiten aplicaciones móviles como Snapchat o Face Swap Live.

La empresa de contenido generado por inteligencia artificial, Metaphysic, ha conseguido algunos de los mejores ejemplos de esta tecnología, como la cuenta viral de TikTok @DeepTomCruise o su intervención en el programa televisivo America’s Got Talent, en el que emplearon esta tecnología para transformar, en directo, el rostro de un concursante en el cuerpo del presentador. También devolvieron a la vida al cantante Elvis Presley en una actuación en directo gracias a esta tecnología.

▶️ Una nueva voz: ‘Lip-sync’

A partir de un vídeo preexistente, se sustituye el contenido de audio para simular que da un mensaje diferente. La nueva cara encajará de tal forma que se haga una sincronización labial.

Un ejemplo es el experimento visual planteado por BuzzFeed Video, en el que el presidente Barack Obama aparecía en un vídeo lanzando un mensaje de advertencia sobre los deepfakes. En los últimos segundos se desvelaba la técnica de lip-sync y el actor que en realidad estaba pronunciando ese mensaje.

▶️ Fusión de dos personas: ‘Puppet-master’

Es uno de los deepfakes más difíciles y de resultados asombrosos, que consiste en utilizar el cuerpo de un actor como base para crear un vídeo nuevo, al que se superpone y fusiona la imagen de otra persona. Si, además, a esto se añaden efectos de audio que recuperen la voz del personaje original, el deepfake será aún más difícil de detectar.

Un ejemplo es el anuncio de Lola Flores para una marca de cervezas, en el que primero se grabó como cuerpo base a una cantaora con apariencia similar a Lola Flores. Después, el deepfake requirió más de 5.000 imágenes de archivo de la artista, cientos de horas de posproducción, con ajustes para asegurar la verosimilitud del modelo, efectos especiales y la voz de su hija.

Pistas para detectar un vídeo falso

Aunque los deepfakes son difíciles de destapar, según LISA Institute hay algunas señales que nos pueden ayudar:

🔴 Fallos

Muchos poseen errores que delatan que se ha manipulado el vídeo: bordes borrosos, piel artificialmente lisa, movimientos entrecortados o diferencias en la iluminación son algunos de ellos.

🔴 Parpadeo

En un deepfake, una persona parpadea menos veces de las que lo haría una persona en un vídeo real. Esto se debe a que el algoritmo no es capaz de parpadear sin evidenciar indicios de falsedad, por lo menos igual de rápido que un ser humano.

🔴 Cuello y cara

Estos vídeos suelen modificar solo los rostros, no el cuerpo entero, ya que esto es más complicado. Si lo que se ve del cuerpo no coincide con la cara, podemos tener una pista más de que se trata de un vídeo falso.

🔴 Sonido

Muchas veces la imagen no se ajusta correctamente con la voz, por lo que no hay una sincronización entre el movimiento de los labios y el sonido.

🔴 Detalles

Es importante conocer toda la información sobre la grabación y, para esto, puede ayudar reproducir el vídeo a velocidad reducida. Si se trata de un deepfake, podremos ver modificaciones repentinas en la imagen o cambios en el fondo del vídeo.

🔴 Boca

Los algoritmos de inteligencia artificial todavía no son capaces de copiar con precisión la lengua, los dientes y el interior de la boca al hablar. Un pequeño fallo en esta parte nos indica que estamos ante un vídeo manipulado.

🔴 Origen

Indagar sobre quién compartió el archivo en primera instancia y en qué redes sociales, así como verificar el contexto en que se publicó y los detalles originales del mismo, pueden ayudarnos a detectarlo.

🔴 Duración

La mayoría de los deepfakes tienen una duración muy corta, de unos segundos. Un vídeo demasiado corto y con un contenido inverosímil puede darnos también una pista.

Quién controla la inteligencia artificial

Más de 1.000 empresarios e investigadores relacionados con la inteligencia artificial —como el fundador de Tesla, Elon Musk, o el cofundador de Apple, Steve Wozniak—, publicaron a finales de marzo una carta abierta en la que solicitaban una moratoria de al menos seis meses en el desarrollo de esta tecnología. El motivo: los últimos avances ya son capaces de competir con los humanos, por lo que podrían usarse para destruir empleo y difundir desinformación. Reclaman un desarrollo seguro que compruebe que sus efectos serán positivos.

En Europa se están dando los primeros pasos para regular el futuro incierto de este tipo de tecnología, con el desarrollo del Reglamento de Inteligencia Artificial (The AI Act), que todavía se está debatiendo en la Unión Europea. Cuando entre en vigor será la primera ley que tenga como objetivo garantizar que los sistemas y aplicaciones de inteligencia artificial que funcionen en Europa sean seguros y respeten los derechos fundamentales y valores de la Unión, al mismo tiempo que aportará un marco jurídico y legal uniforme, que deberán implantar y trasladar los Estados miembros a sus respectivas normativas.

➡️ Agencia Española de Supervisión de la Inteligencia Artificial

España ha sido el primer país en anunciar la creación de la Agencia Española de Supervisión de la Inteligencia Artificial (AESIA), que tendrá potestad certificadora y sancionadora, y velará por el cumplimiento del futuro reglamento europeo. La intención era que la AESIA comenzara a trabajar en el verano de 2023, en la sede designada en A Coruña, pero la Sociedad Civil Juntos por Granada y el propio Ayuntamiento de la ciudad andaluza —que competían junto a otras urbes por alojar la sede— han impugnado la designación y ralentizado su puesta en marcha.

“Está por ver cuáles serán las atribuciones de la AESIA y cómo se va a implementar la regulación europea. La apuesta en España parte de que las empresas tengan unos protocolos de seguridad que se puedan auditar. La AESIA debería crear una herramienta de certificación, como un sello de calidad. Si una empresa consigue ese certificado, podrá demostrar que lo está haciendo bien y los ciudadanos podrán confiar en su producto. Un organismo de certificación, amparado por la AESIA, debería tener personal con conocimiento técnico necesario para demostrar, de forma transparente, que se está haciendo un trabajo de acuerdo a unos principios éticos y a la legislación en vigor. Y si no es así: penalización, multas o retirar ese sello”, reflexiona José María Alonso, profesor de Ciencias de la Computación e Inteligencia Artificial en la Universidad de Santiago de Compostela e investigador del CiTIUS (Centro Singular de Investigación en Tecnoloxías Intelixentes).

Los profesionales que trabajen en la futura AESIA tendrán perfiles técnicos y jurídicos, especializados en nuevas tecnologías y seguridad informática. Sin embargo, José María Alonso recuerda la necesidad de añadir a esos perfiles, profesionales de otras disciplinas, como lingüística, sociología o medicina, que aporten su visión sobre posibles usos y abusos de la inteligencia artificial. “No se puede hacer una regulación que solo se base en el conocimiento de ingenieros y abogados. Debería haber paneles de discusión, en los que se combinen todas las visiones, para hacer un desarrollo multidisciplinar inclusivo”, afirma.